尽管苹果在生成式 AI 热潮开始后并未推出任何 AI 模型,但近期公司正在着手一些 AI 项目。上周,苹果研究人员分享了一篇揭示公司正在研发的新语言模型的论文,内部消息称苹果正在研发两款 AI 驱动的机器人。

如今,又一份研究论文的发布显示苹果才刚刚开始。周一,苹果研究人员发表了一篇研究论文,介绍了 Ferret-UI,这是一个新的多模式大语言模型(MLLM),能够理解移动用户界面(UI)屏幕。

MLLM 与标准 LLM 不同之处在于,它们不仅涉及文本,还展现了对图像和音频等多模式元素的深刻理解。在这种情况下,Ferret-UI 被训练出来识别用户主屏幕的不同元素,如应用程序图标和小文本。过去,由于这些元素的细微特性,对 MLLM 来说识别应用屏幕元素是具有挑战性的。为了克服这个问题,研究论文指出,研究人员在 Ferret 上增加了 “任意分辨率”,使其能够放大屏幕上的细节。

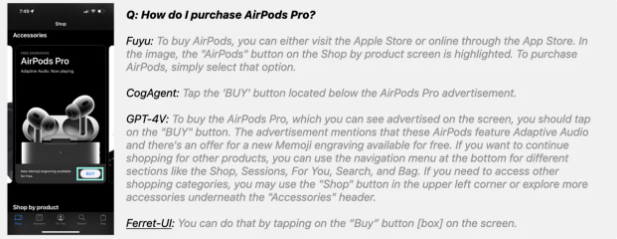

基于此,苹果的 MLLM 还具有 “指代、基础和推理能力”,这使得 Ferret-UI 能够充分理解 UI 屏幕并根据屏幕内容执行任务,如下图所示。

苹果研究人员将 Ferret-UI 与 OpenAI 的 MLLM GPT-4V 在公共基准测试、基础任务和高级任务中进行了比较。在基础任务中,包括图标识别、OCR、小部件分类、查找图标和查找小部件任务在 iPhone 和 Android 上,Ferret-UI 几乎在所有任务上均优于 GPT-4V。唯一的例外是在 iPhone 上的 “查找文本” 任务中,GPT-4V 稍微优于 Ferret 模型。

在对 UI 调查结果进行论证时,GPT-4V 稍微领先,其在推理对话上表现优异,超过了 Ferret93.4% 对91.7%。然而,研究人员指出,Ferret-UI 的表现仍然 “值得关注”,因为它生成原始坐标,而不是 GPT-4V 从中选择的一组预定义框。

论文并未提及苹果计划如何利用这项技术,或者是否会利用。相反,研究人员更广泛地表示,Ferret-UI 的先进功能有望积极影响与 UI 相关的应用。Ferret-UI 可以提升 Siri 的功能。由于模型对用户应用屏幕的全面理解以及执行某些任务的知识,Ferret-UI 可以用于强化 Siri,让其为用户执行任务。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。