在这个信息爆炸的时代,我们每天都在用图片和视频记录生活,分享快乐。但你有没有想过,如果有一种技术,能够让机器像人类一样,不仅能看懂这些图片和视频,还能和我们进行深入的交流,那会怎样?

阿里团队最新发布的通用多模态大模型mPLUG-Owl3,以其惊人的效率和理解能力,让我们在4秒内就能"看"完一部2小时的电影!这不仅仅是一个模型,更像是一个能看、能听、能说、能思考的AI助手。

mPLUG-Owl3,这个名字听起来就像是一只戴着眼镜的猫头鹰,聪明而机警。它的核心能力,就是对长图像序列的理解。不管是一连串的照片,还是一段视频,它都能看懂里面的内容,甚至能够理解其中的故事线。

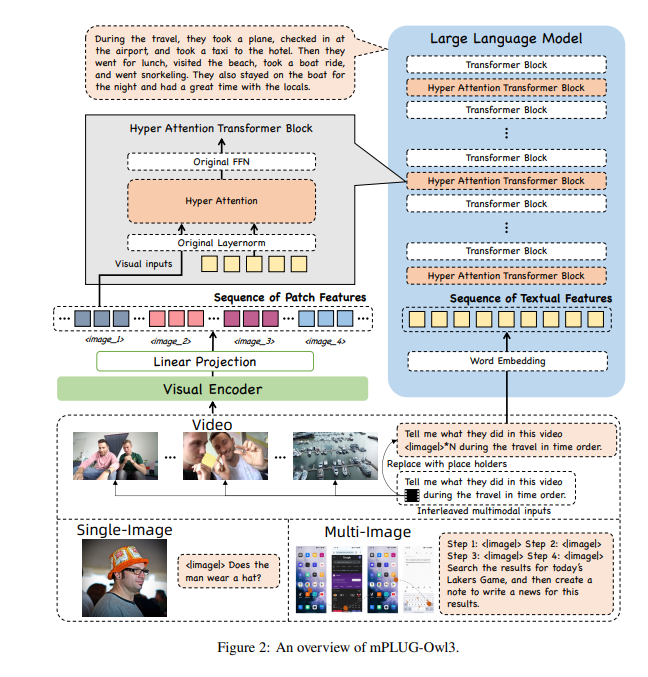

为了让mPLUG-Owl3能够处理这么多信息,研究者们给它装上了一个超级大脑——超注意力模块。这个模块就像是AI的超级大脑,能够同时处理视觉和语言信息,让AI在理解图像的同时,还能够理解与之相关的文本信息。

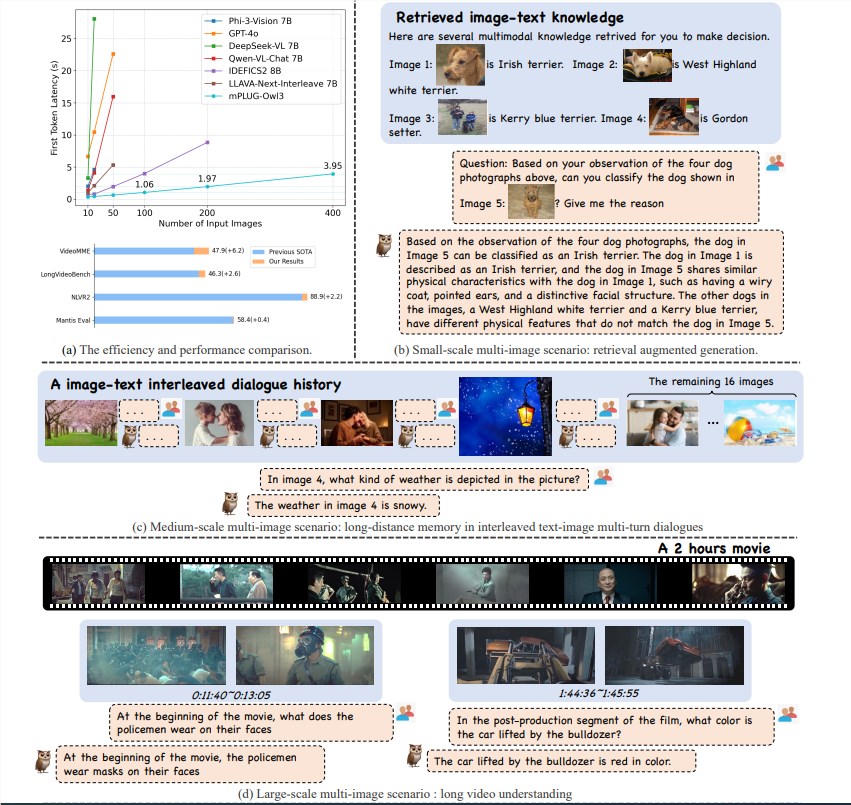

mPLUG-Owl3模型以其卓越的推理效率,在多模态理解领域取得了重大突破。它不仅在单图、多图、视频等多场景Benchmarks上达到了SOTA(State of the Art),而且First Token Latency缩小了6倍,单张A100显卡能处理的图像数目提升了8倍,达到了400张。

mPLUG-Owl3能够准确理解传入的多模态知识,并用于解答问题。它甚至能告诉你它是根据哪一条知识做出的判断,以及详细的判断依据。

mPLUG-Owl3能够正确理解不同材料中的内容关系,进行深入推理。无论是风格差异还是角色识别,它都能轻松应对。

mPLUG-Owl3能够观看并理解长达2小时的视频,4秒内就能开始回答用户的问题,无论问题涉及视频的哪个部分。

mPLUG-Owl3采用了轻量化的Hyper Attention模块,将Transformer Block扩展成能够进行图文特征交互和文本建模的新模块。这种设计大幅度降低了额外引入的新参数,使得模型更容易训练,并且训练和推理效率也得到了提升。

在广泛的数据集上进行实验,mPLUG-Owl3在大多数单图多模态Benchmarks上都取得了SOTA效果。在多图测评中,它超越了专门针对多图场景优化的模型。在LongVideoBench上,它更是超越了现有模型,显示出其在长视频理解方面的卓越能力。

阿里mPLUG-Owl3的发布,不仅是技术上的一次飞跃,更为多模态大模型的应用提供了新的可能性。随着技术的不断完善,我们期待mPLUG-Owl3在未来能够带来更多惊喜。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。