哈尔滨工业大学(深圳)近期发布了名为九天(JiuTian-LION)的多模态大语言模型,通过融合细粒度空间感知和高层语义视觉知识,取得了在13个视觉语言任务上的state-of-the-art性能,尤其在Visual Spatial Reasoning任务上实现了5%的性能提升。

论文链接:https://arxiv.org/abs/2311.11860

GitHub:https://github.com/rshaojimmy/JiuTian

项目主页:https://rshaojimmy.github.io/Projects/JiuTian-LION

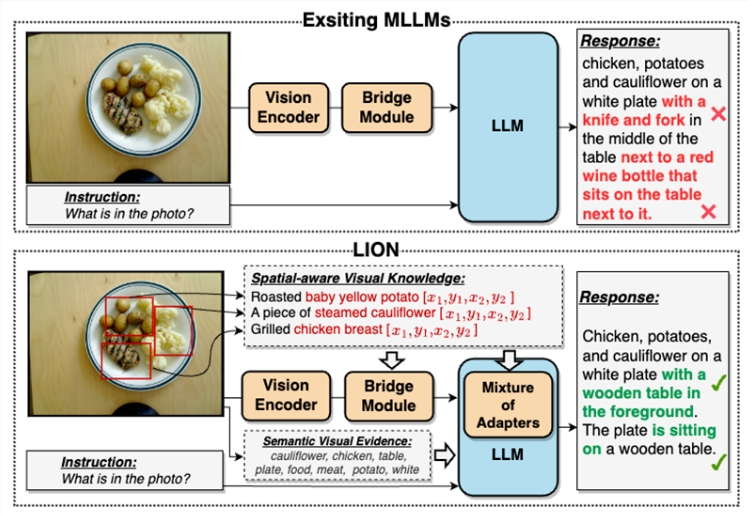

传统的多模态大语言模型在视觉信息提取上存在不足,导致了视觉定位偏差和幻觉等问题。九天模型通过双层视觉知识增强策略,解决了这一问题。

其方法框架包括分段指令微调策略和混合适配器,首次分析了图像级理解任务和区域级定位任务之间的内部冲突,实现了两种任务的互相提升。通过注入细粒度空间感知和高层语义视觉知识,九天在包括图像描述、视觉问题、和视觉定位等17个视觉语言任务上实现了显著的性能提升,其中13个评测任务达到了国际领先水平。

与现有的多模态大语言模型相比,九天通过渐进式融合细粒度空间感知视觉知识和软提示下的高层语义视觉证据,有效地提升了视觉理解能力,生成更准确的文本回应,减少了模型的幻觉现象。总体而言,九天为多模态大语言模型领域带来了新的思路和性能突破,为视觉语言任务的研究提供了有力的支持。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。