英伟达最新推出的Nemotron-4语言模型引起广泛关注。这一通用大模型拥有150亿参数,经过在8T token上的训练,在英语、多语言和编码任务中表现出色。具体而言,Nemotron-4在7个评估基准上的15B模型表现优异,超越同等参数规模的模型,甚至击败了4倍大的模型。

该模型的设计灵感来自Chinchilla模型的「缩放定律」,该定律强调在给定固定计算预算的情况下,同时优化数据和模型大小。与过去主要关注模型大小不同,这一研究强调将计算分配给更多数据的训练,以降低延迟和服务模型所需的计算量。因此,Nemotron-4的主要目标是打造一个能在单个英伟达A100或H100GPU上运行的最佳「通用大模型」。

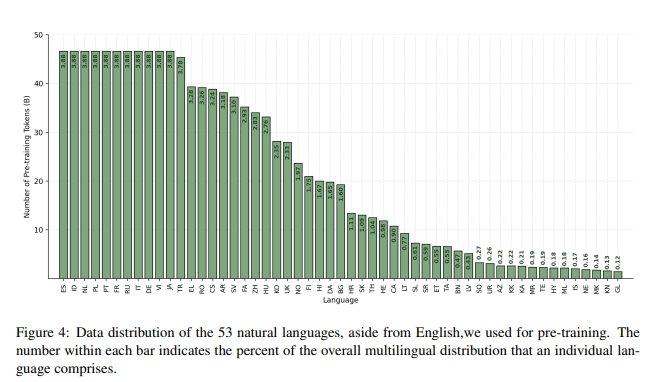

在架构方面,Nemotron-4采用了标准的纯解码器Transformer架构,并带有因果注意掩码。核心超参数包括32亿个嵌入参数和125亿个非嵌入参数。在数据方面,研究人员使用了包含8万亿个token的预训练数据集,分为英语自然语言数据(70%)、多语言自然语言数据(15%)和源代码数据(15%)。

为了实现这一庞大模型的训练,Nemotron-4使用了384个DGX H100节点,每个节点包含8个英伟达H10080GB SXM5GPU。在16位浮点(bfloat16)算术下,每个GPU的峰值吞吐量为989teraFLOP/s。研究人员通过张量并行和数据并行的组合进行训练,并使用了分布式优化器。

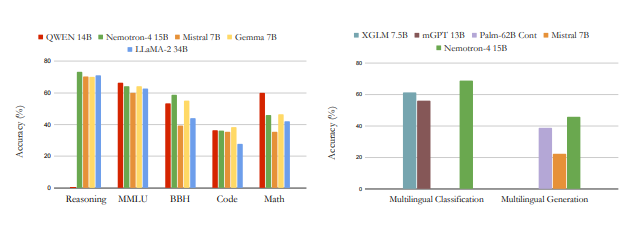

在下游评估中,Nemotron-4在各领域均表现强劲,特别是在常识推理、热门综合基准和数学、代码任务上。该模型在多语言分类和生成任务中也实现了最佳性能,展现了其在不同语言的卓越理解能力。值得注意的是,Nemotron-4在机器翻译任务中取得了显著的进展,不仅在中文翻译成英文方面表现出色,而且在中文直接翻译成其他语言方面也取得了印象深刻的效果。

Nemotron-4的推出标志着英伟达在通用大模型领域的一次重要突破,为单个A100或H100GPU上运行的最佳通用大模型设定了新标准。

论文地址:https://arxiv.org/abs/2402.16819

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。