随着人工智能的快速发展,视觉与语言能力的整合引发了视觉语言模型(VLMs)的突破性进展。这些模型旨在同时处理和理解视觉与文本数据,广泛应用于图像描述、视觉问答、光学字符识别以及多模态内容分析等场景。

VLMs 在开发自主系统、增强人机交互以及高效文档处理工具方面发挥了重要作用,成功地弥合了这两种数据模态之间的差距。然而,在高分辨率视觉数据和多样化文本输入的处理上,仍然存在许多挑战。

目前的研究已经部分解决了这些限制,但大多数模型采用的静态视觉编码器在高分辨率和可变输入尺寸上缺乏适应性。同时,预训练的语言模型与视觉编码器的结合往往导致效率低下,因为它们并未针对多模态任务进行优化。尽管有些模型引入了稀疏计算技术来管理复杂性,但在不同数据集上的准确性仍显不足。此外,现有模型的训练数据集通常缺乏多样性和任务特异性,这进一步限制了其表现。例如,许多模型在图表解读或密集文档分析等专业任务中表现不佳。

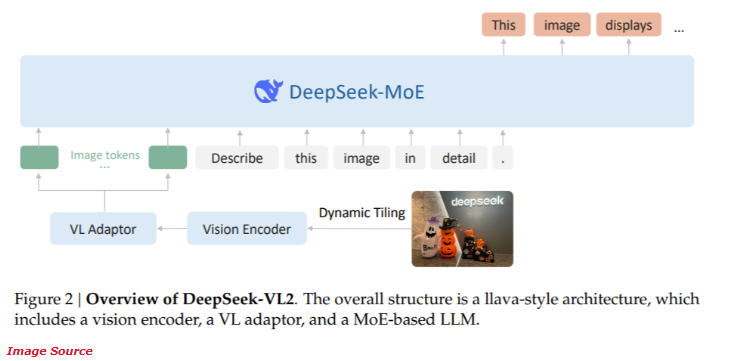

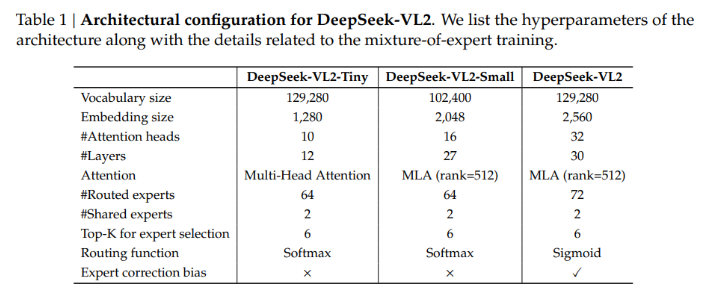

近期,DeepSeek-AI 推出了全新的 DeepSeek-VL2系列开源混合专家(MoE)视觉语言模型。该系列模型结合了前沿创新技术,包括视觉编码的动态切片、多头潜在注意机制以及 DeepSeek-MoE 框架。

DeepSeek-VL2系列提供了三种不同参数配置:

- DeepSeek-VL2-Tiny:33.7亿参数(10亿激活参数)

- DeepSeek-VL2-Small:161亿参数(28亿激活参数)

- DeepSeek-VL2:275亿参数(45亿激活参数)

这种可扩展性确保了其适应不同应用需求和计算预算的能力。

DeepSeek-VL2的架构旨在优化性能,同时降低计算需求。动态切片方法确保高分辨率图像的处理不失关键细节,非常适合文档分析和视觉定位任务。此外,多头潜在注意机制使得模型能够高效处理大量文本数据,降低了通常与处理密集语言输入相关的计算开销。DeepSeek-VL2的训练涵盖了多样化的多模态数据集,使其在光学字符识别、视觉问答和图表解读等多种任务中表现卓越。

根据性能测试,Small 配置在光学字符识别任务中达到了92.3% 的准确率,显著超越现有模型。在视觉定位基准测试中,该模型相比于前代产品提升了15% 的精准度。

同时,DeepSeek-VL2在保持最先进准确率的同时,计算资源的需求减少了30%。这些结果展示了该模型在高分辨率图像与文本处理方面的优越性。

项目入口:https://huggingface.co/collections/deepseek-ai/deepseek-vl2-675c22accc456d3beb4613ab

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。