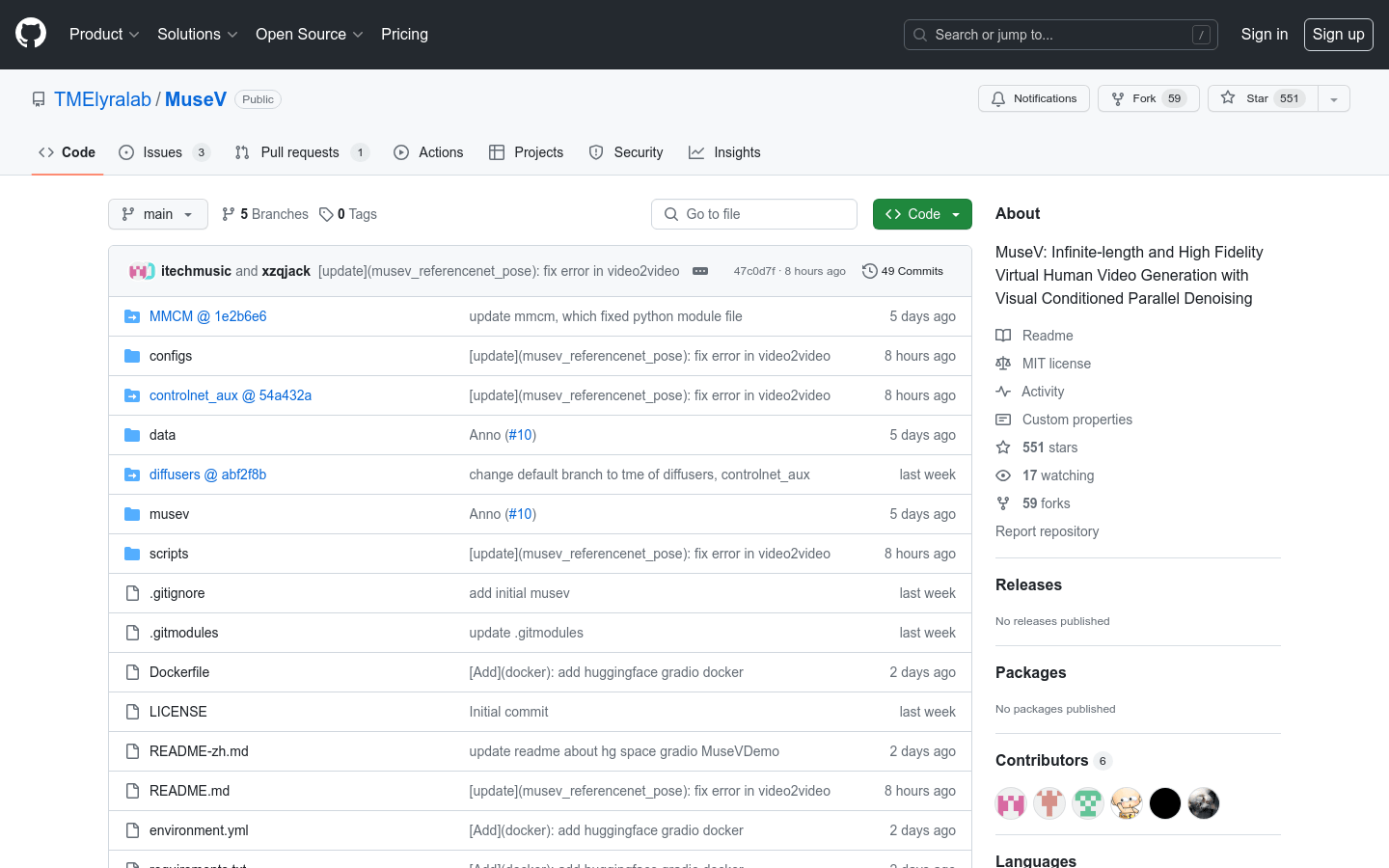

MuseV是一个基于扩散模型的虚拟人视频生成框架,支持无限长度视频生成,采用了新颖的视觉条件并行去噪方案。它提供了预训练的虚拟人视频生成模型,支持Image2Video、Text2Image2Video、Video2Video等功能,兼容Stable Diffusion生态系统,包括基础模型、LoRA、ControlNet等。它支持多参考图像技术,如IPAdapter、ReferenceOnly、ReferenceNet、IPAdapterFaceID等。MuseV的优势在于可生成高保真无限长度视频,定位于视频生成领域。

MuseV官网体验入口https://github.com/TMElyralab/MuseV

谁可以从MuseV中受益?

MuseV适合需要生成虚拟人物视频的用户,包括视频生成、虚拟人物创作、影视动画制作等领域的专业人士。它为内容创作提供了新的可能性和工具,让用户能够创造出独特而高质量的视频内容。

MuseV的实际应用

MuseV的实际应用非常广泛:

- 影视动画制作:可用于创作虚拟人物角色和场景,并生成动画片段。

- 内容创作:通过文本描述和参考图像,创作定制化的视频内容。

- 视频转换:将真实人物视频转换为虚拟人物风格的动画视频,增加创意和趣味性。

- 虚拟人物创作:为游戏开发、虚拟现实等领域创作虚拟人物形象。

虚拟人视频生成的技术背景

MuseV利用了扩散模型和新颖的视觉条件并行去噪方案,以生成高保真的虚拟人视频。它基于先进的算法和模型,结合多参考图像技术,实现了无限长度视频生成的能力,为用户提供了强大的视频创作工具。

MuseV的关键功能

- 无限长度视频生成:支持生成任意长度的视频内容,让用户创作无限可能。

- 多种生成方式:支持文本转视频、图像转视频、视频转视频等多种功能,满足不同场景需求。

- 高保真视频效果:生成的虚拟人视频质量高,栩栩如生,逼真度极高。

- Stable Diffusion生态:兼容该生态系统,拓展了视频生成的可能性和效果。

如何使用MuseV

想要体验MuseV的强大功能,只需要了解其基本操作和功能即可开始创作。用户可以根据自己的需求和创意,选择合适的生成方式和参考图像,轻松生成定制化的虚拟人视频作品。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。