阿里通义实验室最近开源了名为FunAudioLLM的音频生成大模型项目,旨在提升人类与大型语言模型(LLMs)间的自然语音交互体验。该项目由两个核心模型组成:SenseVoice和CosyVoice。

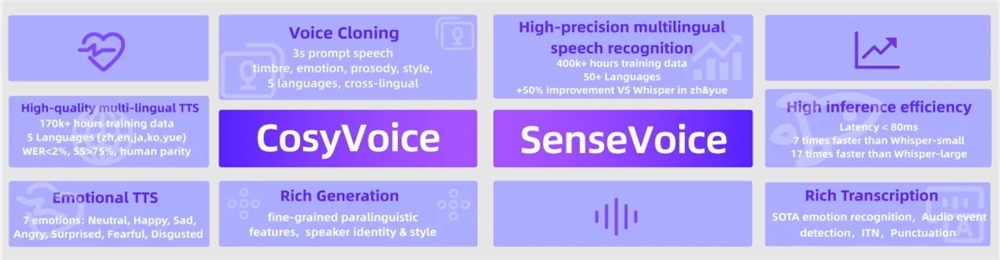

CosyVoice 专注于自然语音生成,具备多语言支持、音色和情感控制功能,在多语言语音生成、零样本语音生成、跨语言声音合成和指令执行方面表现出色。它通过15万小时数据训练,支持中英日粤韩五种语言,能够快速模拟音色并提供情感和韵律的细粒度控制。

SenseVoice 则致力于高精度多语言语音识别、情感辨识和音频事件检测。它经过40万小时数据训练,支持超过50种语言,识别效果优于Whisper模型,尤其在中文和粤语上提升超过50%。SenseVoice还具备情感识别和声音事件检测能力,以及快速的推理速度。

FunAudioLLM支持多种人机交互应用场景,如多语言翻译、情绪语音对话、互动播客和有声读物等。它通过结合SenseVoice、LLMs和CosyVoice,能够实现无缝的语音到语音翻译,情感语音聊天应用程序,以及互动式播客电台。

技术原理方面,CosyVoice基于语音量化编码,支持自然流畅的语音生成,而SenseVoice提供全面的语音处理功能,包括自动语音识别、语言识别、情感识别和音频事件检测。

开源的模型和代码已在ModelScope和Huggingface上发布,同时GitHub上也提供了训练、推理和微调代码。CosyVoice和SenseVoice模型都在ModelScope上有在线体验,方便用户直接尝试这些先进的语音技术。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。