最近,微软研究院与北京航空航天大学的研究团队联合推出了一个名为 E5-V 的全新框架,旨在为多模态嵌入提供一种更高效的解决方案。随着人工智能的不断进步,多模态大语言模型(MLLMs)已经成为研究的热点,它们能够同时理解文本和视觉信息,从而更好地处理复杂的数据关系。但在多模态学习中,有效表示多种信息仍然是一个重大挑战。

项目入口:https://github.com/kongds/E5-V/

以往的模型如 CLIP,虽然通过对比学习将视觉与语言表示对齐,但多数模型仍然依赖于图像和文本对的独立编码器,这导致输入整合的效果不佳。此外,这些模型通常需要大量的多模态训练数据,成本高昂,且在复杂的语言理解和视觉 - 语言任务中表现不足。

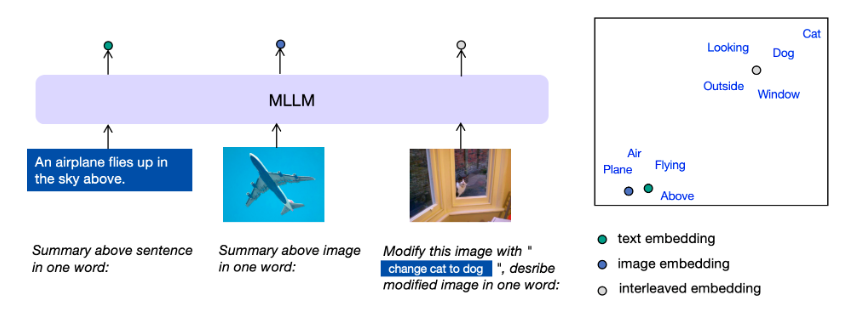

E5-V 框架的创新之处在于,它采用了单模态训练的方式,仅使用文本对进行训练,这样不仅大幅降低了训练成本,也避免了需要收集多模态数据的麻烦。在训练过程中,E5-V 框架通过将多模态输入转化为单词来消除模态差距。这一方法让模型能够更准确地执行诸如复合图像检索等复杂任务。

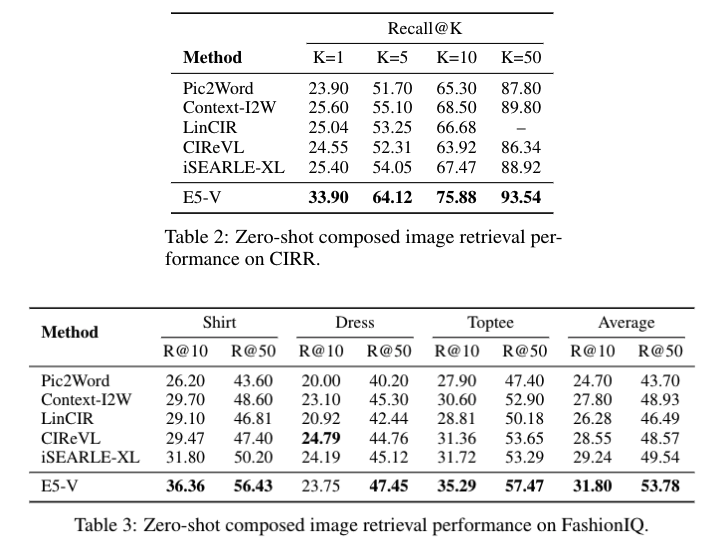

根据研究团队的实验结果,E5-V 在多个任务上的表现都非常出色,比如文本 - 图像检索、复合图像检索等。它在零样本图像检索任务中表现优异,超越了现有的顶尖模型 CLIP ViT-L,在 Flickr30K 和 COCO 数据集上的 Recall@1分别提高了12.2% 和15.0%。

此外,在复合图像检索任务中,E5-V 也超越了目前的最先进方法 iSEARLE-XL,在 CIRR 数据集上提高了8.50% 和10.07%。

E5-V 框架代表了多模态学习的重大进步。通过利用单模态训练和基于提示的表示方法,E5-V 解决了传统方法的局限性,为多模态嵌入提供了更高效、更有效的解决方案。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。