最近,苹果 AI 研究团队推出了他们的新一代多模态大语言模型(MLLMs)家族 ——MM1.5。这一系列模型能够结合文本、图像等多种数据类型,向我们展示了 AI 在理解复杂任务方面的新能力。像视觉问答、图像生成和多模态数据解读这样的任务,都能在这些模型的帮助下得到更好的解决。

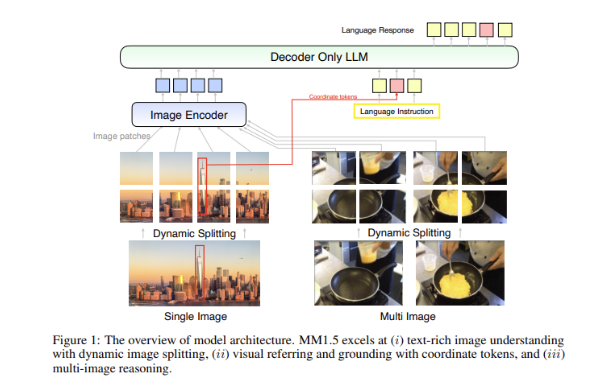

多模态模型的一个大挑战,就是如何在不同数据类型之间实现有效的交互。过去的模型常常在处理文本丰富的图像或者细粒度视觉任务时遇到困难。因此,苹果的研究团队在 MM1.5模型中引入了创新的数据中心化方法,利用高分辨率的 OCR 数据和合成的图像描述,来强化模型的理解能力。

这一方法不仅使 MM1.5在视觉理解和定位任务上超越了以前的模型,同时也推出了两款专门版的模型:MM1.5-Video 和 MM1.5-UI,分别用于视频理解和移动界面分析。

MM1.5模型的训练分为三个主要阶段。

第一阶段是大规模预训练,使用了20亿对图像和文本数据,600百万个交错的图像文本文档,以及2万亿个仅含文本的 token。

第二阶段是通过45百万个高质量 OCR 数据和700万条合成描述的持续预训练,进一步提升文本丰富图像任务的性能。

最后,在监督微调阶段,模型使用经过精心挑选的单图、多图和仅文本的数据进行优化,使其更擅长于细致的视觉引用和多图推理。

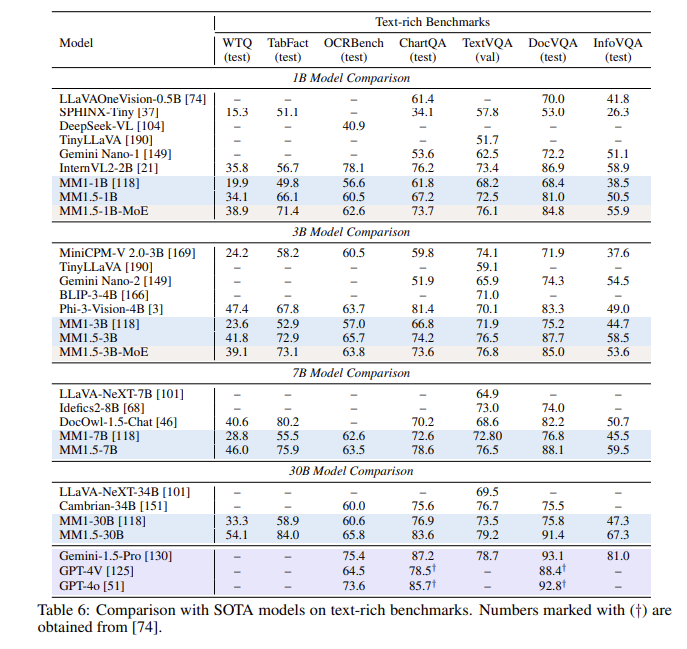

经过一系列评估,MM1.5模型在多个基准测试中表现出色,尤其在处理文本丰富的图像理解时,比之前的模型有了1.4分的提升。此外,即使是专门针对视频理解的 MM1.5-Video,凭借强大的多模态能力,也在相关任务中达到了领先水平。

MM1.5模型家族不仅为多模态大语言模型设定了新的基准,还展示了其在各类应用中的潜力,从一般的图像文本理解到视频和用户界面分析,均有着出色的表现。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。