普林斯顿大学和耶鲁大学的研究人员最近发布了一份关于大语言模型(LLM)“思维链(CoT)”推理能力的报告,揭示了CoT推理的奥秘:它并非纯粹基于逻辑规则的符号推理,而是融合了记忆、概率和噪声推理等多种因素。

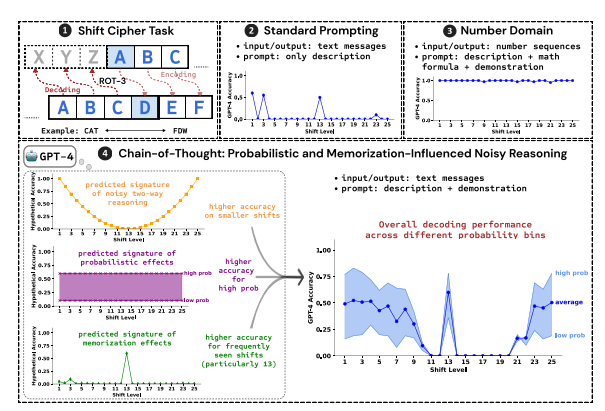

研究人员以破解移位密码为测试任务,分析了GPT-4、Claude3和Llama3.1这三个LLM的表现。移位密码是一种简单的编码方式,每个字母都被替换成字母表中向前移动固定位数的字母。例如,将字母表向前移动3位,"CAT"就会变成"FDW"。

研究结果表明,影响CoT推理效果的三个关键因素是:

概率:LLM更倾向于生成概率较高的输出,即使推理步骤指向的是概率较低的答案。例如,如果推理步骤指向"STAZ",但"STAY"是更常见的单词,LLM可能会“自我修正”并输出"STAY"。

记忆:LLM在预训练过程中记住了大量文本数据,这会影响其CoT推理的准确性。例如,rot-13是最常见的移位密码,LLM在rot-13上的准确率明显高于其他类型的移位密码。

噪声推理:LLM的推理过程并非完全准确,而是存在一定程度的噪声。随着移位密码的位移量增加,解码所需的中间步骤也随之增加,噪声推理的影响也更加明显,导致LLM的准确率下降。

研究人员还发现,LLM的CoT推理依赖于自我条件化,即LLM需要明确生成文本作为后续推理步骤的上下文。如果LLM被指示“默默思考”而不输出任何文本,其推理能力就会大幅下降。 此外,演示步骤的有效性对CoT推理的影响并不大,即使演示步骤存在错误,LLM的CoT推理效果依然可以保持稳定。

这项研究表明,LLM的CoT推理并非完美的符号推理,而是融合了记忆、概率和噪声推理等多种因素。LLM在CoT推理过程中既表现出记忆大师的特点,也展现了概率高手的风范。这项研究有助于我们更深入地理解LLM的推理能力,并为未来开发更强大的AI系统提供 valuable insights。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。