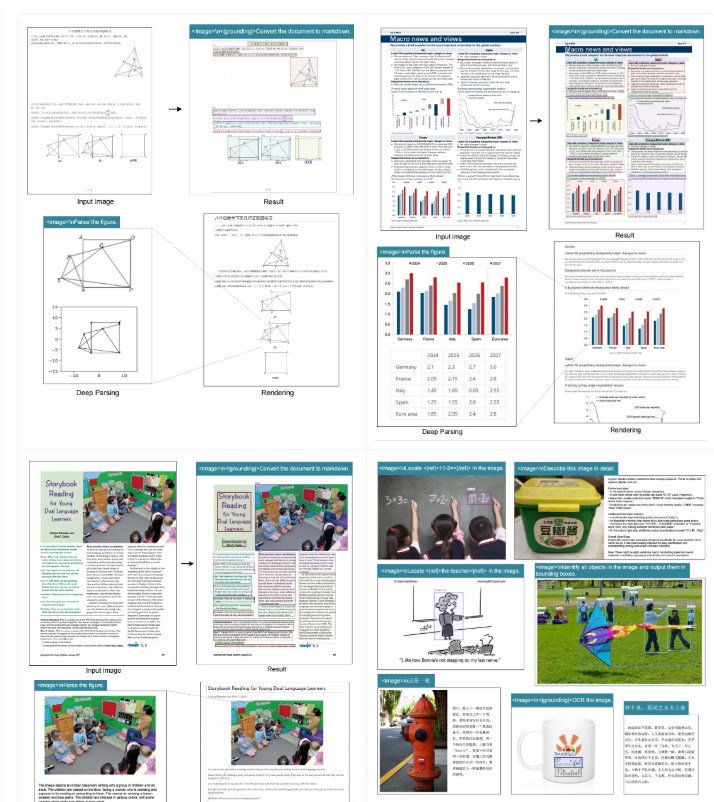

AI 技术公司 DeepSeek 近日推出了一款名为 “DeepSeek-OCR” 的全新光学字符识别(OCR)模型。这款模型是一种端到端的视觉语言模型(VLM),旨在通过将长文本压缩为一小组视觉标记,随后利用语言模型进行解码,从而实现高效的文档解析。

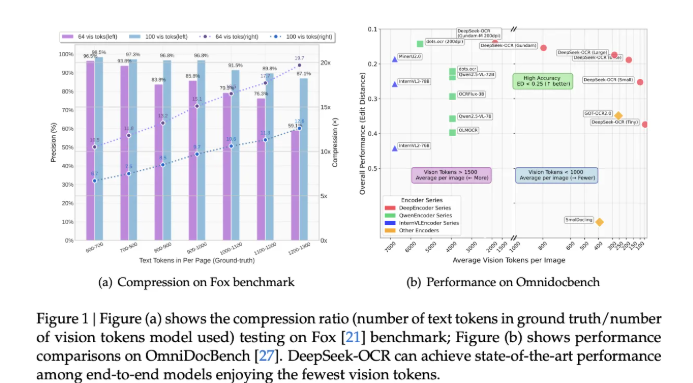

研究团队表示,该模型在 Fox 基准测试中实现了97% 的解码精度,当文本标记数与视觉标记数的比例为10倍时,精度依然保持良好,甚至在20倍压缩下也能表现出有用的特性。此外,DeepSeek-OCR 在 OmniDocBench 基准测试中也表现出色,使用的视觉标记数量远少于传统模型。

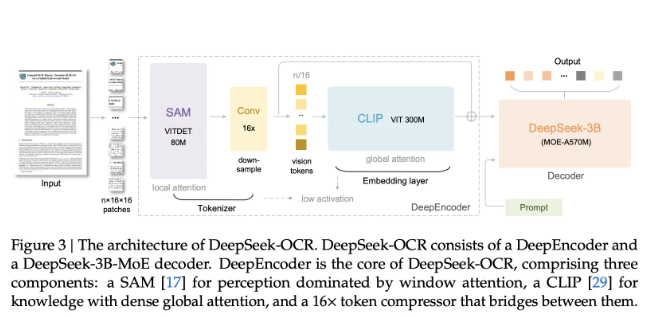

DeepSeek-OCR 的架构由两个主要组件组成:高分辨率输入的视觉编码器 DeepEncoder 和一个名为 DeepSeek3B-MoE-A570M 的专家混合解码器。该编码器采用了一种基于 SAM 的局部感知窗口注意机制和卷积压缩算法,能够有效控制高分辨率下的激活内存,并减少输出标记的数量。解码器则是一个拥有30亿参数的模型,每个标记有约5.7亿个活跃参数。

在使用不同的模式时,DeepEncoder 提供了多种分辨率选择,包括 Tiny、Small、Base 和 Large 模式,分别对应不同的视觉标记数量和分辨率。此外,还有动态模式 Gundam 和 Gundam-Master,可以根据页面复杂性灵活调整标记预算。

在训练过程中,DeepSeek 团队使用了分阶段的训练流程,首先对 DeepEncoder 进行下一个标记预测的训练,然后在多个节点上进行全系统的训练,最终每天能够生成超过20万页的文档。对于实际应用,团队建议用户从 Small 模式开始,如果页面包含密集的小字体或高标记数量,可以选择 Gundam 模式。

DeepSeek-OCR 的发布标志着文档人工智能领域的一次重要进步。该模型的高效性和灵活性使其在处理各种文档时都具备了良好的适应性。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。