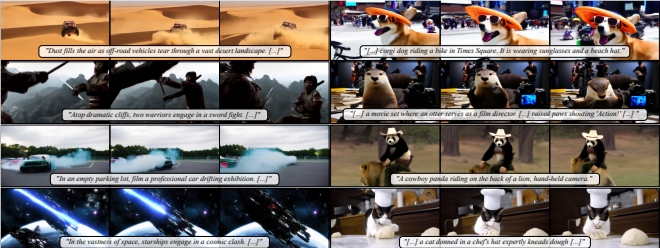

在数字媒体时代,视频已成为我们表达自己、分享故事的主要方式。但高质量视频的创作通常需要专业技能和昂贵的设备。现在,通过Snap Video,你只需用文字描述你想要的场景,就能自动生成视频。

当前的图像生成模型已经展现出卓越的质量和多样性。受此启发,研究者开始将这些模型应用于视频生成。然而,视频内容的高度冗余性使得直接将图像模型应用于视频生成领域,会降低动作的真实性、视觉质量和可扩展性。

Snap Video是一个以视频为中心的模型,系统性地解决了这些挑战。首先,它扩展了EDM框架,考虑了空间和时间上的冗余像素,自然支持视频生成。其次,它提出了一种基于变换器的新型架构,比U-Net训练速度快3.31倍,推理速度快4.5倍。这使得Snap Video能够高效地训练具有数十亿参数的文本到视频模型,首次达到最先进的结果,并生成质量更高、时间一致性和动作复杂性显著的视频。

技术亮点:

时空联合建模:Snap Video能够合成具有大幅度运动的连贯视频,同时保留大规模文本到视频生成器的语义控制能力。

高分辨率视频生成:采用两阶段级联模型,先生成低分辨率视频,再进行高分辨率上采样,避免了潜在的时间不一致性问题。

基于FIT的架构:Snap Video利用了FIT(Far-reaching Interleaved Transformers)架构,通过学习压缩的视频表示,实现了高效的时空计算联合建模。

Snap Video在UCF101和MSR-VTT等广泛采用的数据集上进行了评估,表现出在生成动作质量方面的特别优势。用户研究也表明,Snap Video在视频文本对齐、动作数量和质量方面优于最新的方法。

论文还讨论了视频生成领域的其他研究工作,包括基于对抗训练或自回归生成技术的方法,以及最近在文本到视频生成任务中采用扩散模型的进展。

Snap Video通过将视频作为一等公民来对待,系统性地解决了扩散过程和架构在文本到视频生成中的常见问题。它提出的修改EDM扩散框架和基于FIT的架构,显著提高了视频生成的质量和可扩展性。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表本站立场。